Un estudio publicado en la revista Nature propone el primer decodificador neural que utiliza la forma en que se representan en el cerebro los sonidos y los movimientos de los labios, la lengua y la mandíbula cuando conversamos para sintetizar el habla humana.

Para las personas que sufren un trastorno neurológico que afecta su comunicación, mantener una conversación correcta y fluida podría llegar a ser posible otra vez.

Al menos esa es la posibilidad que sugiere un equipo de especialistas norteamericanos que utilizaron 5 personas para demostrar la efectividad de una “prótesis neural del habla”.

Muchos pacientes con parálisis causada por desórdenes neurológicos como la esclerosis lateral amiotrófica pierden la capacidad de expresarse. En su mayoría, optan por dispositivos alternativos de comunicación que miden movimientos de la cabeza o los ojos.

Otra posibilidad son las interfaces cerebro-ordenador que ayudan a controlar el cursor y seleccionar letras una a una para formar palabras. Sin embargo, estos métodos no permiten una correcta aproximación a la conversación humana, principalmente por la velocidad de emisión.

Una novedosa publicación de la revista Nature asegura que esta situación está a punto de cambiar.

También puede interesarte leer: ¿Pueden los gatos realmente discriminar su nombre? Un estudio de la Universidad de Tokio plantea que sí

La prótesis neural del habla que permite sintetizar oraciones completas

El habla humana se caracteriza por la emisión de aproximadamente 150 palabras por minuto. Mientras que los dispositivos creados hasta el momento solo permiten sintetizar unas 10 palabras en el mismo período de tiempo.

El objetivo del equipo de investigadores de la Universidad de California San Francisco y la Universidad de California Berkeley era demostrar la viabilidad de un nuevo método que traduce las señales cerebrales para sintetizar expresiones audibles a la velocidad de un emisor normal.

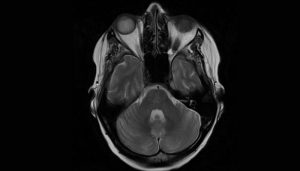

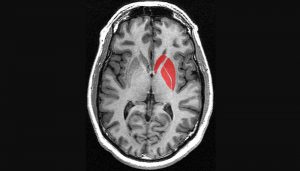

El estudio incluyó 5 pacientes cuyo cerebro estaba siendo monitoreado intracranealmente para un tratamiento de epilepsia y que no tenían el habla afectada. Los especialistas grabaron señales electrocorticográficas de alta densidad (monitoreo del córtex) mientras los participantes pronunciaban cientos de oraciones a viva voz.

De esta manera fue posible integrar la forma en que movían los labios, la lengua y la mandíbula, los sonidos que emitían y cómo esta actividad era representada en el cerebro.

El equipo fue capaz de diseñar una red neural que decodificaba las señales corticales para producir frases habladas. Las grabaciones resultantes fueron escuchadas por numerosas personas en forma de test de transcripción en la plataforma Amazon Mechanical Turk.

Según Anumanchipalli y sus colaboradores, el método resultó totalmente efectivo, reproduciendo el habla de los participantes con una gran similitud. Las audiciones fueron transcritas acertadamente en el 69% de los casos, siendo algunas palabras más difíciles que otras.

Por esta razón, la síntesis de expresiones mediante grabaciones corticales directas de la zona cortical del habla parece ser una vía prometedora para devolver la comunicación a los pacientes afectados.

Revisa además: Es ciencia, pero no ficción: una combinación de luz y sonido es capaz de mejorar los síntomas de alzhéimer en ratones

Emocionantes perspectivas futuras

De acuerdo con los investigadores, las prótesis de control neural fueron probadas primero en participantes sin afectaciones y, más adelante, en pacientes con tetraplejia que no podían expresarse. Aunque estas investigaciones aún muestran resultados preliminares, todo parece indicar que, a pesar de no haber practicado con el decodificador, un individuo con parálisis puede ser capaz de emplearlo.

Es la primera vez que un decodificador es capaz de reproducir el habla humana en un ritmo muy parecido al natural e incorporando nuevo vocabulario.

Sin embargo es necesario continuar este estudio para seguir desarrollando la tecnología y comprobar su posible uso a gran escala.

También puede interesarle leer: El síndrome del acento extranjero crónico también podría representar un desorden neurológico funcional

Fuentes bibliográficas

Anumanchipalli G. K., J. Chartier & E. F. Chang. Speech synthesis from neural decoding of spoken sentences, Nature, 2019. 568: 493-510. En: www.nature.com/articles/s41586-019-1119-1

University of California San Francisco (2019). Synthetic speech generated from brain recordings. En: https://medicalxpress.com/news/2019-04-synthetic-speech-brain.html

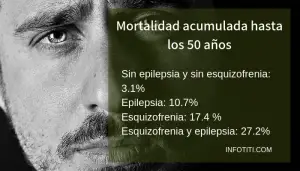

- Más de una de cada cuatro personas con epilepsia y esquizofrenia muere entre los 25 y 50 años, según lo observado en un estudio danés - 2019-05-23

- Las enfermedades mentales graves, ¿tienen una huella cerebral común? - 2019-05-22

- Cuando el primer tratamiento farmacológico para la depresión no ha funcionado, ¿cómo elegir el siguiente? - 2019-05-17